Quelle: iStock.com/deepblue4you

Quelle: iStock.com/deepblue4you

Neue Betrugsmasche dank KI-Voice-Cloning übers Smartphone

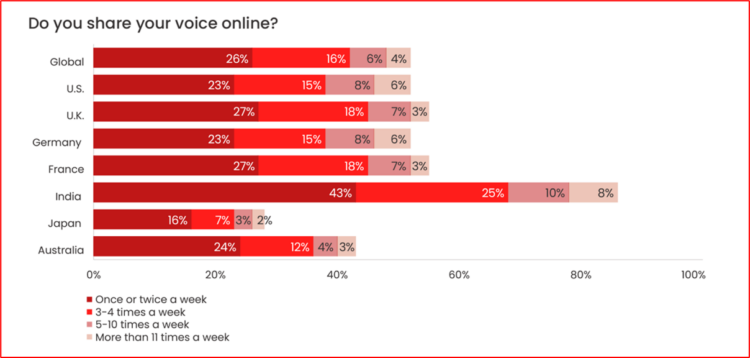

4. Juli 2023 Veröffentlicht von Raphael DoerrKünstliche Intelligenz ist auf dem Vormarsch: Kaum ein Tag vergeht, an dem in den sozialen Medien nicht von neuen, vermeintlich hilfreichen KI-Tools berichtet wird. So kann hochentwickelte KI mittlerweile ganze Pop-Songs erstellen, täuschend echte Fotos anfertigen oder sogar menschliche Stimmen imitieren. Letzteres nutzen jetzt Betrüger aus und rufen mit geklonter Stimme übers Smartphone an. Die Stimme eines jeden Menschen ist einzigartig, das gesprochene Äquivalent zu einem biometrischen Fingerabdruck. Deshalb ist es ein weithin akzeptierter Weg, Vertrauen zu schaffen, wenn man jemanden sprechen hört. Da jedoch 53 % der Erwachsenen mindestens einmal pro Woche ihre Stimmdaten online weitergeben, etwa über soziale Medien, Sprachnotizen usw., ist das Klonen der Stimme heute für Profis ein Kinderspiel.

Wie die Tageszeitung Ruhr24 berichtet, werden mittels KI-Sprachgeneratoren Stimmen von Freunden oder Familienangehörigen – wie beispielsweise den eigenen Kindern – repliziert. Die Verwandten werden dann auf ihrem Smartphone von einer KI-generierten Stimme angerufen, die von der des echten Kindes oder Freundes so gut wie nicht zu unterscheiden ist. Wie beim bekannten Enkeltrick werden die Opfer dann um Geld gebeten, um aus einer vermeintlichen Notlage zu helfen. Die besorgten Angehörigen lassen sich durch die täuschend echte Klon-Stimme oftmals überzeugen und dazu verleiten, den Betrügern Geld zu überweisen. Von der neuen KI-Masche hatte erstmalig die Washington Post im März berichtet. In den USA ist sie demnach schon seit Längerem im Umlauf. Nach einem Bericht von Sat.1 hätten geschädigte US-Amerikaner insgesamt bereits mehrere Millionen Euro verloren.

Sicherheitsexperten warnen

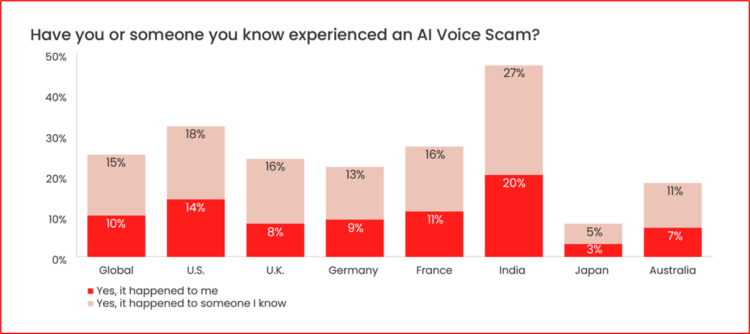

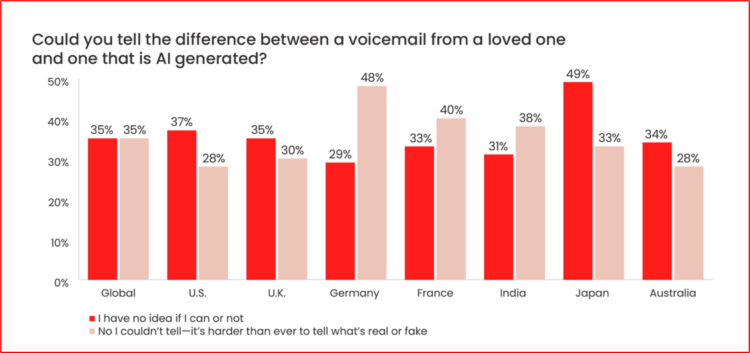

Die Sicherheitsexperten von McAfee widmen dieser Betrugsmasche Ende Mai einen ganzen Report. Die Untersuchungen zeigen, dass Betrüger KI-Technologie einsetzen, um Stimmen zu klonen und dann eine gefälschte Sprachnachricht zu versenden oder die Kontakte des Opfers anzurufen, um vorzutäuschen, in Not zu sein. 70 % der Erwachsenen sind sich nicht sicher, ob sie die geklonte Version von der echten unterscheiden könnten, und so ist es keine Überraschung, dass diese Technik an Fahrt gewinnt.

Fast die Hälfte (45%) der Befragten gab an, dass sie auf eine Sprachnachricht antworten würden, die vorgibt, von einem Freund oder einer geliebten Person zu stammen, der/die Geld braucht, insbesondere wenn sie glauben, dass die Anfrage von ihrem Partner oder Ehepartner (40 %), einem Elternteil (31 %) oder einem Kind (20 %) stammt. Bei den Eltern über 50 Jahren ist die Wahrscheinlichkeit am größten, dass sie einem Kind antworten (41 %). Am ehesten antworteten Nachrichten, in denen behauptet wurde, der Absender sei in einen Autounfall verwickelt gewesen (48%), ausgeraubt worden (47%), habe sein Telefon oder seine Brieftasche verloren (43%) oder benötige Hilfe auf einer Auslandsreise (41%). Die Cyber-Experten sind sich sicher, dass diese Art von KI-Abzocke mittels gefakter Stimmen in der nächsten Zeit weiter zunehmen wird. Gemäß ihrer Umfrage seien bereits jetzt mehr als 20 Prozent der Deutschen einmal mit einer mittels KI gefälschten Stimme in Berührung gekommen – beispielsweise in den sozialen Medien.

KI Voice Cloning nennt sich die Technik, die dabei angewandt wird. Es handelt sich um eine sogenannte Deepfake-Technik, die menschliche Stimmen analysiert und dann klont. Der KI genügt dabei ein kurzer Stimm-Ausschnitt, der heutzutage in sozialen Medien, Sprachnachrichten und Ähnlichem überall zu finden ist. Es gibt bereits zahlreiche entsprechende KI-Sprachklon-Programme, die dazu in der Lage sind, Stimmen originalgetreu nachzuahmen. Einige lassen sich sogar ganz einfach in den gängigen App-Stores herunterladen. Die Technologie wird bereits in der Film- und Spieleindustrie sowie für Content in den sozialen Medien verwendet.

Kommentar

Kommentar

DE

DE